Искусственный интеллект стал неотъемлемой частью нашей повседневной жизни, и одной из самых захватывающих технологий в этой области является GPT (Generative Pre-trained Transformer).

GPT - это нейронная сеть, обученная на огромном количестве текстов, способная генерировать человекоподобные тексты в полностью автоматическом режиме. Эта технология настолько продвинута, что может использоваться в самых разных областях, от создания контента до помощи в научных исследованиях.

Однако использование GPT на полную мощность может быть сложной задачей для новичков. В этой статье мы расскажем о том, как максимально эффективно использовать GPT и получить от него максимум пользы.

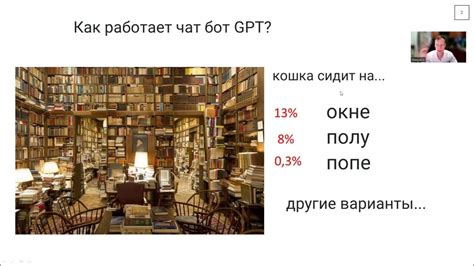

Принцип работы GPT и алгоритмы обучения

Принцип работы GPT основан на методе обучения с подкреплением – модель обучается на большом количестве текстовых данных, чтобы "понять" правила языка и последовательности слов. Однако, в отличие от нейронных сетей, для обучения GPT используется несколько дополнительных алгоритмов, позволяющих улучшить его качество и довести его до полной мощности.

Изначально модель GPT обучается в несколько этапов. На первом этапе применяется алгоритм Pre-training, в рамках которого модель обучается на огромном корпусе текстов – например, всем доступным в части Интернета. В ходе этого обучения модель учится распознавать грамматические и семантические закономерности в тексте.

После этого происходит этап Тонкая настройка, на котором модель обучается на более узком наборе данных, связанных с конкретной задачей – например, создание текстов определенной тематики. Здесь модель дополняется специфическими знаниями и навыками в выбранной области.

Подготовка данных для использования GPT

Для достижения наиболее эффективного использования модели GPT (Generative Pre-trained Transformer), необходимо правильно подготовить тренировочные данные.

Данные для GPT должны быть в текстовом формате, который является основным для модели. Текст может быть простым файлом .txt или текстовой базой данных.

Данные должны быть структурированы согласно требованиям GPT. Каждое предложение должно быть разделено на отдельные строки и правильно токенизировано.

Важно, чтобы данные для тренировки были чистыми и без ошибок, так как GPT запоминает информацию из данных.

Данные для GPT могут быть подготовлены различными инструментами и технологиями, такими как языковые модели и алгоритмы обработки естественного языка.

Правильная подготовка данных важна для эффективного использования модели GPT в различных приложениях, таких как генерация текста, машинный перевод, чат-роботы и другое.

Выбор и настройка гиперпараметров GPT

У моделей GPT есть множество гиперпараметров, которые нужно настроить для достижения хороших результатов. Правильный выбор гиперпараметров может существенно влиять на производительность модели.

Один из важных гиперпараметров GPT - количество слоев в модели. Большее количество слоев дает более абстрактную и сложную модель, но требует больше ресурсов. Выбор количества слоев зависит от задачи и ресурсов.

Другой важный гиперпараметр - размер скрытого пространства модели. Большая размерность может улучшить модель, но увеличивает память и сложность. Для некоторых задач нужно экспериментировать и подбирать оптимальный размер.

Также следует обратить внимание на регуляризацию GPT. Гиперпараметры регуляризации помогают контролировать переобучение и улучшить обобщающую способность. Можно использовать dropout, weight decay и другие методы.

Оптимизация и скорость обучения важны для работы модели. Выбор оптимального оптимизатора и настройка скорости обучения могут улучшить результаты.

Также важен размер батча и количество эпох обучения. Большой размер батча ускорит обучение, но может снизить обобщающую способность модели. Количество эпох должно быть достаточным для сходимости модели, но не излишне, чтобы избежать переобучения.

При выборе гиперпараметров GPT учитывайте цели задачи, вычислительные ресурсы и временные ограничения. Экспериментирование с разными значениями гиперпараметров и анализ их влияния на результаты важны для использования GPT на полную мощность.

Важно: Параметры модели должны выбираться аккуратно и с учетом потребностей конкретной задачи. Неправильный выбор гиперпараметров может привести к нежелательным результатам и низкой производительности модели.

Применение GPT для генерации текста

Применение GPT для генерации текста разнообразно и может быть полезным в различных областях:

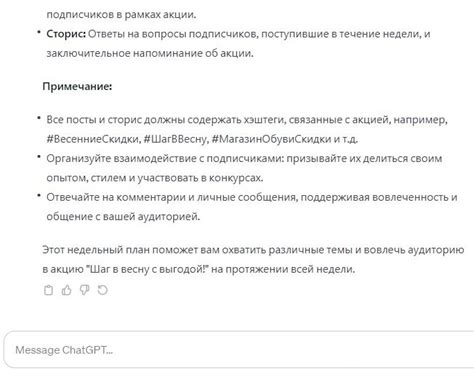

- Генерация контента для социальных сетей и блогов

- Автоматическое создание описаний для товаров в электронной коммерции

- Создание автоматических ответов на письма и обращения клиентов

- Генерация субтитров для видео и аудио материалов

- Создание текстовых заданий и вопросов для обучающих платформ

- Генерация текстов для маркетинговых материалов и рекламных кампаний

GPT может быть применен в любой области, где необходима автоматическая генерация текста. Благодаря передовым алгоритмам и обучению на больших объемах данных, модели GPT становятся все более точными и превосходят другие методы генерации текста.

Однако, несмотря на всю свою мощность, использование GPT требует осторожности. Важно обеспечить адекватность и качество генерируемого контента, а также обрабатывать случаи возможного биаса или нежелательных результатов. Без должного контроля и обучения, модели GPT могут создать текст, который носит ошибочный, оскорбительный или непотребный характер.

Применение GPT в машинном переводе

GPT обучается на текстах на одном языке, чтобы предсказывать следующее слово в предложении. Затем модель дообучается на парах предложений на разных языках для машинного перевода.

Преимущество GPT в машинном переводе заключается в том, что она улавливает контекст и синтаксис целевого языка для качественного перевода. GPT учится на большом количестве текстов, что помогает понимать особенности разных языков и производить точный перевод.

Использование GPT в машинном переводе имеет свои ограничения. Например, GPT может неправильно интерпретировать неоднозначности или отсутствие контекста в тексте. Также могут возникнуть проблемы с переводом слов или фраз, которых нет в целевом языке, и потребуется ручная коррекция.

В целом, GPT ускоряет и улучшает процесс перевода между разными языками. Однако важно помнить об ограничениях и следить за качеством перевода, особенно при обработке специфических данных.

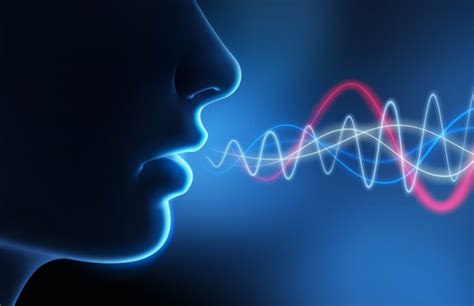

Использование GPT в распознавании речи

Модель GPT (Generative Pre-trained Transformer) преобразовала область обработки естественного языка (Natural Language Processing, NLP). Она может применяться не только для текста, но и для распознавания речи.

Это сложная задача, которая требует работы с аудиоданными и их преобразования в текст. GPT использует глубокое обучение и трансформеры, чтобы успешно справляться с этим.

Одним из плюсов использования GPT в распознавании речи является способность обрабатывать длинные аудиофайлы без потери контекста. Благодаря обучению на большом объеме данных, модель может выявлять сложные зависимости в речевых сигналах и правильно их интерпретировать.

Преимущество GPT в распознавании речи заключается в его способности создавать качественные текстовые результаты благодаря многослойной архитектуре и использованию контекста.

Однако для использования GPT в задачах распознавания речи необходимо обладать большим объемом данных для обучения, таких как аудиофайлы с текстовыми подписями.

Использование GPT в задачах распознавания речи открывает новые возможности для создания более эффективных систем автоматического распознавания и интерпретации речи. Это помогает сделать процесс преобразования аудиоданных в текст более точным и понятным, и может быть полезно в различных областях, например, в ассистентах, интерактивных системах и технологиях распознавания голоса.

Практические примеры применения GPT

Модель GPT (Generative Pre-trained Transformer) открывает множество возможностей для решения разнообразных задач в области обработки естественного языка (Natural Language Processing, NLP). Ниже приведены несколько практических примеров использования GPT:

1. Генерация текста: GPT может использоваться для автоматической генерации текстов, включая новостные статьи, маркетинговые материалы и художественные произведения.

2. Ответы на вопросы:GPT может обучаться для отвечания на вопросы, что пригодно для создания чат-ботов, систем автоматического ответа и других систем общения с клиентами.

3. Перевод текста: GPT может использоваться для автоматического перевода текстов с одного языка на другой. Это удобно для работы с многоязычными данными или создания систем машинного перевода.

4. Распознавание и анализ текста: GPT обучается распознавать и анализировать текст. Это помогает классифицировать тексты по темам, определять настроение и ключевые фразы.

5. Генерация кода: GPT используется для создания программного кода. Это помогает автоматизировать разработку и создавать новые алгоритмы.

Это только несколько примеров использования GPT. С увеличением доступности данных и вычислительной мощности модель GPT сможет решать еще больше задач в области обработки естественного языка.