Энтропия важно в физике и термодинамике. Оценка беспорядка в системе связана с энтропией. Чем выше энтропия, тем больше беспорядка. Как найти эту энтропию? Давайте разберемся.

Способов вычисления энтропии несколько, но простым и удобным является использование формулы Больцмана. По этой формуле, энтропия системы равна натуральному логарифму от количества доступных микростояний системы. Микростояния - все возможные комбинации расположения и движения молекул или частиц в системе.

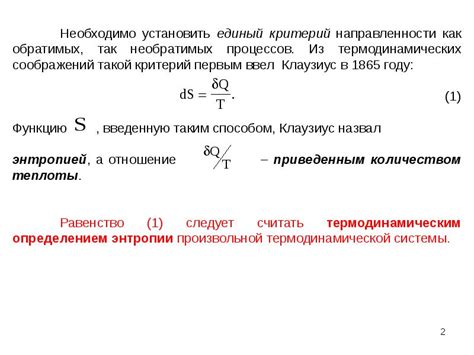

Другой метод вычисления энтропии - использование температуры системы. Согласно второму закону термодинамики, энтропия системы вычисляется как отношение полученной теплоты к температуре системы. Формула выражается как S = Q/T, где S - энтропия, Q - полученная теплота, T - температура системы.

Выбор метода вычисления энтропии зависит от конкретной ситуации. Однако для обоих методов необходимо знать некоторые параметры системы, такие как количество микростояний или температура. В некоторых случаях можно использовать упрощенные модели для оценки энтропии системы.

В чем смысл энтропии?

С точки зрения статистической механики, энтропия определяется как логарифм от числа микросостояний системы, то есть способов распределения энергии между частицами при заданных условиях.

Самое упорядоченное состояние системы имеет наименьшую энтропию, а наиболее хаотичное - наибольшую.

Энтропия играет важную роль в физике, особенно во втором законе термодинамики. Согласно этому закону, энтропия изолированной системы всегда стремится увеличиваться со временем. То есть система без внешнего воздействия будет двигаться к более хаотичному и неупорядоченному состоянию.

Смысл энтропии заключается в том, что она определяет, насколько система приближена к состоянию равновесия или полной упорядоченности. Более высокая энтропия указывает на большую степень хаоса, неопределенности и неупорядоченности в системе.

Таким образом, понимание смысла энтропии позволяет анализировать энергетические, термодинамические и статистические свойства системы, а также предсказывать ее развитие и динамику.

Что такое энтропия в физике?

Энтропия обозначается символом S и является характеристикой системы, измеряющей вероятность появления определенного состояния. Чем больше энтропия, тем меньше вероятность упорядоченности.

Второй закон термодинамики утверждает, что энтропия всегда возрастает в изолированной системе. Это означает, что система всегда стремится к более хаотичному состоянию.

В физике энтропия используется в термодинамике, статистической механике, информационной теории и космологии. Она помогает уточнять прогнозы и анализировать поведение системы в зависимости от условий и внешних факторов.

Понимание энтропии в физике играет важную роль в изучении систем и процессов в природе, а также в различных технических и научных областях.

Причины и понятие энтропии

Одной из основных причин появления энтропии в системах является второй закон термодинамики. Он утверждает, что энтропия изолированной системы всегда будет стремиться увеличиваться или оставаться постоянной. Это естественное динамическое поведение системы, когда она переходит от упорядоченного состояния к неупорядоченному, более вероятному.

Энтропия также связана с распределением энергии или информации в системе. При равномерном распределении энергии или информации энтропия системы будет низкой. Если энергия или информация сосредоточены в определенных частях системы, то энтропия будет высокой.

Понимание и измерение энтропии системы позволяют установить природу изменения состояния системы со временем. Энтропия применяется в различных областях физики - от термодинамики до квантовой механики и помогает описывать поведение систем на микро- и макроуровнях.

Как рассчитать энтропию системы?

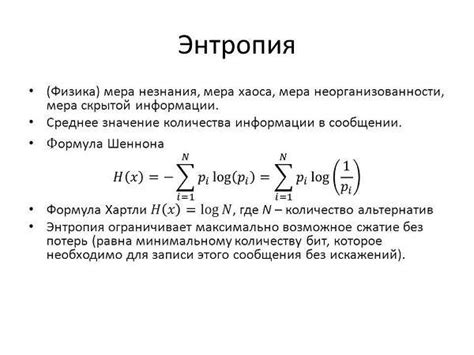

S = -Σ P(i) * log2(P(i))

где S - энтропия системы, P(i) - вероятности состояний системы, а log2 - логарифм по основанию 2.

Для расчета энтропии системы необходимо выполнить следующие шаги:

- Определить вероятности состояний системы. Необходимо знать количество состояний и их вероятности, которые можно выразить в виде десятичных дробей или процентов.

- Посчитать логарифмы вероятностей состояний системы по основанию 2. Для каждой вероятности вычислить логарифм.

- Умножить каждую вероятность на соответствующий логарифм.

- Сложить все произведения из предыдущего шага.

- Умножить полученную сумму на -1, чтобы получить значение энтропии системы.

| Состояние | Вероятность, Р(i) | Логарифм по основанию 2 | Призведение Р(i) * log2(P(i)) |

|---|---|---|---|

| 1 | 0.2 | -2.32 | -0.464 |

| 2 | 0.3 | -1.74 | -0.522 |

| 3 | 0.5 | -1 | -0.5 |

Сумма значений в столбце "Призведение Р(i) * log2(P(i))" равна -1.486.

После умножения на -1 получаем значение энтропии системы S = 1.486.

Таким образом, энтропия системы составляет 1.486.

Энтропия и второй закон термодинамики

Чем более упорядочена система, тем ниже ее энтропия. Например, одинаковое количество идеальных газовых молекул может быть упаковано в различные конфигурации, включая упорядоченную и хаотичную. Упорядоченная конфигурация будет иметь низкую энтропию, в то время как хаотичная конфигурация будет иметь высокую энтропию.

Принцип увеличения энтропии согласуется с наблюдаемым поведением природных процессов. Все природные системы имеют склонность к нарастанию беспорядка, и второй закон термодинамики объясняет эту тенденцию. Энтропия также отражает необратимость процессов: большинство физических изменений системы невозможно обратить без дополнительного внешнего вмешательства.

Увеличение энтропии приводит к потере энергии в форме тепла, которая не может быть использована для работы. Именно поэтому машины теряют часть энергии в виде тепловых потерь и не могут быть идеальными.

В таблице ниже показано изменение энтропии в различных процессах:

| Система | Изменение энтропии |

|---|---|

| Изолированная система, необратимый процесс | Увеличение |

| Изолированная система, обратимый процесс | Постоянная |

| Система, взаимодействующая с окружающей средой | Увеличение |

Энтропия - важное понятие в физике и термодинамике, понимание которой позволяет объяснить множество природных процессов и явлений.

Применение энтропии в реальной жизни

Энтропия - понятие, которое нашло свое применение в различных областях жизни, не только в науке. Концепция энтропии имеет практическое значение и может помочь в объяснении и анализе различных процессов.

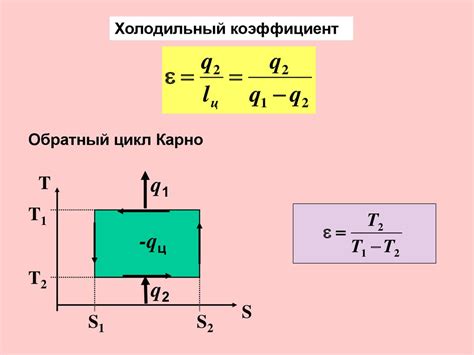

1. Энтропия в теплотехнике. В тепловых двигателях, таких как паровые или внутреннего сгорания, энтропия является важным показателем эффективности работы системы. Чем выше энтропия, тем менее эффективна система и меньше доступна ее энергия.

2. Энтропия в экономике. Идея энтропии применяется в экономике. Экономические системы, как физические системы, стремятся к увеличению энтропии. Без принятия мер предотвращения система становится хаотичной и непредсказуемой. Энтропия помогает анализировать изменения в экономических структурах и разрабатывать стратегии для снижения хаоса и увеличения устойчивости экономической системы.

3. Энтропия в информатике. В информационных технологиях роль энтропии важна в криптографии и стеганографии. Высокая энтропия в криптографии означает большую случайность из-за сложности алгоритмов. Низкая энтропия связана с прогнозируемостью и шаблонами, используемыми для сжатия данных в стеганографии.