Существует несколько способов обнаружения и удаления дубликатов в датафреймах. Один из простых и эффективных методов - использовать функцию drop_duplicates(). Эта функция удаляет все повторяющиеся строки из датафрейма, оставляя только уникальные значения.

Чтобы удалить дубликаты из датафрейма, нужно вызвать функцию drop_duplicates() на самом датафрейме. По умолчанию функция сохраняет первую встреченную строку, удаляя остальные. Однако можно изменить это поведение, указав параметру keep другое значение, например, last, чтобы сохранить последнюю строку среди дубликатов.

Удаление полностью дублирующихся строк

Удаление полностью дублирующихся строк выполняется с помощью метода drop_duplicates(). Этот метод позволяет удалить все строки, которые полностью совпадают с другими строками.

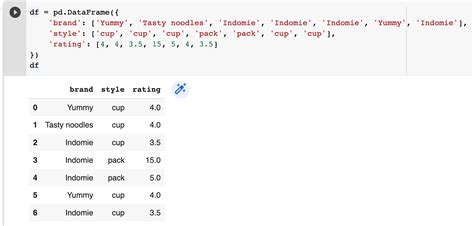

Пример использования метода drop_duplicates() для очистки датафрейма от полностью дублирующихся строк:

import pandas as pd

data = {'A': [1, 2, 3, 1, 2, 3],

'B': ['a', 'b', 'c', 'a', 'b', 'c']}

df = pd.DataFrame(data)

df = df.drop_duplicates()

print(df)

В данном примере датафрейм содержит два полностью дублирующихся наблюдения (строки 1, 2, 3 полностью повторяются), которые удаляются с помощью метода drop_duplicates(). Результат выполнения программы будет следующим:

A B

0 1 a

1 2 b

2 3 c

После использования метода drop_duplicates() все полностью дублирующиеся строки были удалены, оставив только уникальные строки.

Метод drop_duplicates() также позволяет указать столбцы, по которым нужно проверить наличие дубликатов. Например, чтобы удалить строки с одинаковыми значениями в столбце 'A', можно использовать:

df = df.drop_duplicates(subset='A')

Таким образом, drop_duplicates() упрощает процесс очистки датафрейма от полных дубликатов, улучшая точность анализа данных.

Удаление частичных дубликатов

Один из способов удаления частично повторяющихся строк в датафрейме - использование метода duplicated(). Данный метод возвращает булеву маску, указывающую, является ли каждая строка дубликатом предыдущей строки. Для удаления дубликатов можно использовать метод drop_duplicates(). При этом можно указать, какие столбцы необходимо учитывать при определении дубликатов.

Пример использования метода drop_duplicates() для удаления частично повторяющихся строк:

import pandas as pd

df = pd.DataFrame({'A': [1, 1, 2, 2, 3], 'B': ['a', 'b', 'c', 'd', 'e'], 'C': [10, 10, 20, 20, 30]})

print(df)

df.drop_duplicates(subset=['A', 'C'], inplace=True)

print(df)

В данном примере датафрейм содержит столбцы A, B и C. Строки 1 и 2 частично повторяются: значения в столбцах A и C совпадают, а значения в столбце B различаются. Метод drop_duplicates() с параметром subset=['A', 'C'] удаляет такие строки, оставляя только первую строку с уникальными значениями в столбцах A и C.

Используя метод drop_duplicates(), можно легко и эффективно очистить датафрейм от частично повторяющихся строк, оставив только уникальные значения в определенных столбцах.

Удаление строк на основе одного или нескольких столбцов

Необходимо удалить повторяющиеся строки в датафрейме на основе значения одного или нескольких столбцов. Это может потребоваться, когда нужно избавиться от дублирующихся данных или оставить только уникальные значения для анализа.

Для удаления повторяющихся строк на основе одного столбца используется метод drop_duplicates(). Он удаляет строки, в которых значение указанного столбца повторяется.

Пример использования:

df.drop_duplicates(subset=['Название товара'], inplace=True)

В данном примере метод drop_duplicates() использует параметр subset для определения столбцов, по которым нужно проверить дубликаты. Параметр inplace=True указывает на то, что изменения нужно внести непосредственно в исходном датафрейме df.

Если необходимо удалить строки на основе нескольких столбцов, можно передать список названий этих столбцов в параметр subset. Например, если у нас есть столбцы "Название товара" и "Цена", и мы хотим удалить строки с одинаковыми названиями товаров и ценами, можно использовать следующий код:

df.drop_duplicates(subset=['Название товара', 'Цена'], inplace=True)

Метод drop_duplicates() удаляет повторяющиеся строки в датафрейме.

Использование индексов для удаления повторяющихся строк

Индексы в датафрейме уникально идентифицируют каждую строку.

Функция duplicated() возвращает булеву маску, указывающую, является ли строка повторяющейся.

Пример:

df.drop_duplicates(keep='first', inplace=True)

В данном примере функция drop_duplicates() удаляет все повторяющиеся строки, оставляя только первую встретившуюся строку. Параметр keep='first' указывает на сохранение первой встретившейся строки и удаление остальных.

Таким образом, использование индексов и функции drop_duplicates() позволяет быстро и эффективно удалить повторяющиеся строки из датафрейма.

Использование функции drop_duplicates()

Функция drop_duplicates() в pandas позволяет удалять повторяющиеся строки из датафрейма. Это полезная операция при обработке данных, особенно когда нужно избежать ошибочных результатов или оставить только уникальные значения.

Для удаления повторяющихся строк в DataFrame используйте функцию drop_duplicates(). По умолчанию она оставляет только первую уникальную строку.

Чтобы оставить последнюю уникальную строку, укажите параметр keep='last'. Для удаления всех повторов используйте параметр keep=False.

Также можно использовать параметр subset, чтобы выбрать определенные столбцы для поиска повторов. Например, subset=['column_name'].

Также есть возможность использовать параметр inplace=True, чтобы изменить датафрейм без создания нового объекта. В этом случае функция drop_duplicates() возвращает None.

| Исходный датафрейм | Уникальные строки |

|---|---|

| 1 A 2.5 2 B 1.8 3 A 2.5 4 C 3.2 | 1 A 2.5 2 B 1.8 4 C 3.2 |

В таблице выше показан пример использования функции drop_duplicates(). Исходный датафрейм содержит 4 строки, но после применения функции остаются только уникальные строки.

Использование функции duplicated()

Синтаксис функции duplicated() выглядит следующим образом:

| Параметр | Описание |

|---|---|

subset | Столбцы, по которым необходимо проводить проверку на дублирование |

keep | Определяет, какие из дублирующихся строк следует пометить как True |

По умолчанию функция duplicated() возвращает логическое значение True для всех повторяющихся строк, кроме первой. Опция subset позволяет указать столбцы, по которым следует проводить проверку, а опция keep позволяет контролировать помечание дублирующихся строк.

Пример использования функции duplicated() для очистки датафрейма от повторяющихся строк:

import pandas as pd

# Создание датафрейма с повторяющимися строками

data = {'Название': ['Apple', 'Samsung', 'Apple', 'Microsoft'],

'Цена': [1000, 800, 1000, 1200]}

df = pd.DataFrame(data)

# Печать исходного датафрейма

print("Исходный датафрейм:")

print(df)

# Проверка на дублирование и очистка датафрейма

df_unique = df[~df.duplicated()]

# Вывод очищенного датафрейма

print("Очищенный датафрейм:")

print(df_unique)

После выполнения этого кода будет получен очищенный датафрейм без повторяющихся строк:

Исходный датафрейм:

Название Цена

0 Apple 1000

1 Samsung 800

2 Apple 1000

3 Microsoft 1200

Очищенный датафрейм:

Название Цена

0 Apple 1000

1 Samsung 800

3 Microsoft 1200

Использование функции duplicated() помогает легко и быстро удалить дублирующиеся строки в датафрейме, что полезно для анализа данных и работы с машинным обучением.

Методы удаления дубликатов строк

Иногда стандартные методы не могут полностью очистить датафрейм от повторяющихся строк. В таких случаях можно использовать комбинированные методы для более точной фильтрации данных.

Один из таких методов - использование функции duplicated вместе с функцией drop_duplicates. Функция duplicated находит все повторяющиеся строки, а функция drop_duplicates удаляет все повторы, оставляя только первые строки.

Также можно указать столбцы, по которым нужно проверять наличие дубликатов, передав их имена в параметр subset. Это исключает удаление строк, в которых значения разных столбцов совпадают, но значения в других столбцах отличаются.

Также можно изменить поведение функции drop_duplicates с помощью параметра keep. По умолчанию он установлен на значение first, что означает оставить первое вхождение каждой уникальной строки. Вариант last оставляет последнее вхождение каждой уникальной строки, а вариант False удаляет все повторы.

Пример комбинированного метода удаления повторяющихся строк:

# Импортирование библиотеки pandas

import pandas as pd

# Создание датафрейма с повторяющимися строками

data = {'Name': ['John', 'John', 'Alice', 'Bob', 'Alice'],

'Age': [25, 25, 30, 35, 30]}

df = pd.DataFrame(data)

# Поиск и удаление повторяющихся строк

df = df.drop_duplicates(subset=['Name', 'Age'], keep='first')

print(df)

Приведенный код удаляет повторяющиеся строки с именами "John" и "Alice", оставляя только первые вхождения каждой уникальной строки.